Les représentations de l'énergie du vide spatial par les sciences physiques

L'éther et l'énergie de l'espace

selon la physique quantique

Alain Boudet

Dr en Sciences Physiques

3. L'éther et l'énergie de l'espace quantique

3. L'éther et l'énergie de l'espace quantiqueRésumé: L'espace dans lequel se meuvent électrons et galaxies est-il vide ou plein? De tout temps, les philosophies traditionnelles ont énoncé qu'une substance non-matérielle précède la création matérielle et sous-tend toute chose. Les physiciens ont longtemps admis l'existence d'un éther, jusqu'à l'avènement de la Relativité Restreinte et les expériences de Michelson. Dès lors, ils considèrent que l'espace est vide. Mais cette vision ne fait pas l'unanimité et suscite des controverses. La physique quantique réinvente l'éther sans le nommer sous l'appellation d'énergie quantique du point zéro. C'est l'énergie du champ électromagnétique qui subsiste lorsque la température descend au zéro absolu et qui produit une mer fourmillante de particules éphémères. L'évaluation de la valeur de cette énergie conduit selon les modèles mathématiques envisagés, soit à une énergie infinie qu'on ramène à zéro par un artifice, soit à une énergie finie mais gigantesque. De son côté, la cosmologie a été amenée à inventer une énergie noire qui pourrait s'identifier à l'énergie du vide quantique... si sa valeur n'était pas terriblement plus basse.

Selon les investigations de la science, effectués par les appareils d'observation et de détection qu'elle a mis au point, notre Univers est constitué de matière et de rayonnements. Matière et rayonnements prennent place et se meuvent dans un immense espace où se déroulent les événements cosmiques, aussi bien à l'échelle des étoiles et des galaxies que dans l'intérieur des atomes.

Si nous parlons d'espace, envisageons-nous un espace théorique abstrait de description des phénomènes, ou une réalité physique, voire historique qui nous fait remonter à la création? Si on enlève la matière, est-il possible de définir un espace qui serait le cadre de ces jeux? Lorsque nous tentons de répondre à ces interrogations, nous touchons un mystère, celui de la Nature et de l'origine de l'Univers.

Il n'y a évidemment pas de réponse définitive au questionnement sur la nature de l'Univers et sa création. Du point de vue strictement scientifique, il y a seulement des hypothèses, des spéculations et une variété de théories tentant de rendre compte des phénomènes atomiques, sous-atomiques et cosmiques. Cet article a pour objet de dresser un panorama des théories actuelles telles qu'elles sont présentées majoritairement par le courant universitaire ou acédémique. D'autres théories et recherches, souvent révolutionnaires et puissantes, seront présentées dans des articles ultérieurs. Toutes décrivent un Univers plein d'énergie, même en l"absence de matière.

Les philosophies et religions anciennes décrivent elles-aussi un Univers plein d'une énergie primordiale. Variées et élaborées, elles nourrissent notre imagination et activent notre intuition, et peuvent servir de guide à notre pensée pour appréhender l'Univers dans lequel nous vivons et qui sert de cadre à notre évolution (voir article Le sens de la Vie).

La conviction qu'une substance remplit l'Univers est rapportée dans la plupart des traditions ethniques, spirituelles ou religieuses sous une forme ou sous une autre. Le monde manifesté a été créé, ou est perpétuellement recréé, à partir d'une substance primordiale qui remplit l'espace. Cette substance imprègne intimement toutes les choses et tous les êtres vivants. Elle est le milieu qui les unifie en un vaste Tout. On l'imagine soit comme une sorte d'eau subtile, soit comme un filet aux mailles extrêmement fines. Elle a la capacité de transmettre des influences et des impulsions créatrices.

La façon dont le monde est créé à partir de cette substance varie d'une mythologie à l'autre. Il peut être l’œuvre de Dieu ou de dieux, ou de principes de vie fondamentaux qui régissent l'univers et l'espace. Souvent, dieux et déesses utilisent le souffle ou le son (voir article Aspects géométriques et sonores de l'Univers).

La tradition hindoue la plus ancienne nous est connue par les textes du Véda, qui contiennent la connaissance éternelle et unique. Ils ont été complétés par des textes fondateurs de l'hindouisme, tels que les Upanishad. Plusieurs courants philosophiques en sont issus, dont le Samkhya. Dans la Subala Upanishad, et dans le Samkhya, sont précisés le nombre et la nature des constituants de l'Univers.

Le Samkhya énonce qu'une substance subtile primordiale nommée Prakriti sous-tend toute existence physique. Elle est le principe créateur de l'existence physique de tous les corps et de tous les objets, matériels ou subtils, dans tout l'Univers, de l'électron à la galaxie, de la bactérie aux organes. Elle reçoit des impulsions d'un autre principe, Pourousha, qui est l'Esprit Suprême, la cause première intentionnelle du monde. Prakriti est constituée de 3 aspects, les gounas, qui correspondent à des qualités spécifiques et sont des composantes de tout objet. Comme ces qualités sont en interaction dynamique, les objets sont en évolution constante. L'évolution suit des cycles qui s'achèvent avec la dissolution de l'objet qui retourne à l'état de prakriti.

Le jeu de l'évolution conduit à produire des éléments de nature mentale, psychique et sensorielle. Les éléments les plus grossiers, c'est-à-dire les plus proches de la densité matérielle sont au nombre de 5. C'est d'abord l'éther (Akasha) qui est associé à la qualité de l'espace. Il produit l'air (légèreté), le feu (énergie), l'eau (fluidité) et la terre (forme), qui sont chacun associés à une qualité. Le mot Akasha signifie briller, rayonner. L’Akasha est invisible et pénètre tout l'espace, toutes les choses. Elle devient visible localement en se densifiant en des manifestations. C'est dans cette substance que se produisent des mouvements, le prana, qui est la respiration de la vie, le rythme de l'univers.

Il est intéressant de remarquer que la substance primordiale se manifeste sur deux niveaux différents, la Prakriti et l'Akasha, le premier se situant sur un plan plus schématique, plus abstrait, plus principiel que le deuxième.

Dans la tradition kabbalistique hébraïque, nous trouvons une substance cosmique primitive nommée Shékinah, qui est issue de la lumière de Dieu ou Ain Soph Or. Elle représente l'énergie féminine de l'Univers, créatrice des manifestations de l'Univers. Sa contre-partie chrétienne est le Saint-Esprit.

Avec les philosophes grecs, la connaissance se simplifie, devient plus matérielle. L'univers est rempli d'un champ d'énergie nomme aether ou éther. Le mot éther (αιθηρ) est dérivé de aíthô, qui a la signification d'être suspendu dans les airs et d'illuminer le ciel par sa brillance. Selon Pythagore, c'est une matière céleste, pure et homogène, distincte de l'air ordinaire αηρ qui est impur et hétérogène.

De même Platon (Le Timée) distingue deux espèces d'air: L’un, grossier et rempli de vapeur, est celui que nous respirons; l’autre, plus subtil, est l’éther, dans lequel les corps célestes sont plongés et y accomplissent leurs révolutions. Les leçons de Platon font référence à des connaissances qui viennent de civilisations antérieures, et il est très probable que l'existence de l'éther était connue de civilisations anciennes ayant une connaissance scientifique avancée (voir article La nouvelle grille cristalline et l'évolution des consciences).

Les Amérindiens Hopis ont des traditions de sagesse et de connaissance qui sont transmises oralement depuis des millénaires par leurs chamanes. Ils vivent actuellement tant bien que mal dans les territoires pauvres qui leur ont été laissés dans l'Arizona. Les traditions incluent des prophéties concernant notre époque qui est sujette à des transformations profondes. Elles mettent en garde sur notre responsabilité et sur la nécessité de faire régner la paix, le respect et l'amour sur toute la planète, car toutes les vies sont reliées par le principe du Tout et interagissent (voir article Prophéties Hopis). Leurs récits accordent une place importante à la Grand-Mère Araignée, qui est présente dès les origines du monde. Elle a pour rôle de tisser la toile de l'Univers. La toile représente la trame de l'Univers, qui en assure l'unité.

Le concept d'éther a naturellement nourri les recherches scientifiques jusqu'au début du 20e siècle, bien que la façon dont il est envisagé ait perdu son contexte d'origine et soit devenue plus matérielle.

Au 17e siècle, on invoquait l'éther pour expliquer l'élasticité de certains matériaux sonores, en imaginant qu'il se frayait un chemin dans les espaces poreux trop étroits du matériau. Pour expliquer comment la vapeur d'eau occupe beaucoup plus d'espace que l'eau liquide, le mathématicien français Claude Dechales dit en 1690: On pourrait supposer entre les parcelles infiniment petites de l’eau l’existence d’une matière très subtile, élastique, impondérable, et c’est cette matière qui viendrait remplir l’espace que les petites parcelles pesantes auraient laissé par leur écartement (Dechales, Tractatus de meteoris, in Mundo mathemat, t. IV, p. 669, Lyon 1690, cité par Ferdinand Hoefer, Histoire de la Physique et de la Chimie, 1872).

La notion d'éther a été invoquée essentiellement pour expliquer des phénomènes liés à la lumière. Pendant très longtemps, les physiciens ont supposé que la lumière se propageait dans un fluide, l'éther, de la même façon que le son voyage dans l'air ou que les vagues glissent à la surface d'un milieu liquide (article Matière et rayonnements). Si la lumière des étoiles parvient jusqu'à nous, pensaient-ils, c'est que l'éther doit remplir tout l'espace.

Ainsi, en 1664, Robert Hooke (physicien, astronome et naturaliste britannique, 1635 - 1703) publia un Traité de Micrographie dans lequel il expose ses conceptions sur la nature de la lumière. D'après lui, la lumière est produite par de petits mouvements vibratoires d’un milieu subtil, homogène (éther), mouvements transmis dans tous les sens comme les rayons partant du centre d’une sphère. Les phénomènes de réflexion et de réfraction à l'interface de deux milieux résultent de densités différentes de l'éther dans ces deux milieux.

Christiaan Huygens (physicien et astronome hollandais, 1629 - 1695) décrivait la lumière comme une onde qui se propage dans un éther luminifère. Pour expliquer la double réfraction de la lumière dans le spath d’Islande, il suppose que la lumière produit deux types d’ondes dans l’éther. Les unes sont sphériques et produisent la réfraction ordinaire, les autres sont ellipsoïdiques (Huygens, Traité de la Lumière, Leyde, 1690).

La théorie d'une lumière due à la vibration de l'éther était également adoptée par Thomas Young (physicien, médecin et égyptologue britannique, 1773 - 1829). Elle expliquait aussi pourquoi la lumière se propage plus lentement dans un milieu matériel que dans l'air. Selon Augustin Fresnel (physicien français, 1788 - 1827), c'est parce que l'onde lumineuse trouble le fluide (éther) qui à son tour ré-émet des ondes, et ces ondes se composent en une onde résultante plus lente.

De son côté, Isaac Newton (physicien et astronome anglais, 1643 – 1727) ne rentrait pas dans ces considérations, puisque pour lui la lumière était constituée de corpuscules. Mais dans son autre domaine d'investigation, l'astronomie, il avait élaboré sa théorie de la gravitation. Or il était insatisfait de cette situation où une force se transmet à travers le vide. Il imagine donc un éther qui transmettrait les influences mécaniques gravitationnelles. Dans une lettre à Richard Bentley, il écrit en 1692: Que la gravité soit innée, inhérente et essentielle à la matière, en sorte qu'un corps puisse agir sur un autre à distance au travers du vide, sans médiation d'autre chose par quoi et à travers quoi leur action et leur force puissent être communiquées de l'un à l'autre, est pour moi une absurdité dont je crois qu'aucun homme, ayant la faculté de raisonner de façon compétente dans les matières philosophiques, puisse jamais se rendre coupable. Il conçoit donc une espèce d'esprit très subtil qui pénètre à travers tous les corps solides, et c'est par la force et l'action de cet esprit que les particules des corps s'attirent mutuellement. (Principia, livre III)

En étudiant les phénomènes électriques et magnétiques, Michael Faraday (physicien et chimiste britannique, 1791 - 1867) constate que des charges ou des fils électriques sont influencés à distance. En saupoudrant une feuille placée contre des aimants ou des fils électriques avec de la limaille de fer, il voit se matérialiser leurs lignes de force. Il pensait donc qu'il fallait qu'il y ait un milieu préexistant dans tout l'espace. Lorsqu'on introduit un corps électrique ou magnétique, il subit la force de ce milieu. Cette vision donnera naissance au concept de champ, mais Faraday le voit comme une substance.

La conception de la propagation de la lumière en tant qu'une onde dans l'éther a été étendue à toutes les ondes électromagnétiques en 1861 par James Clerk Maxwell (physicien et mathématicien écossais, 1831 - 1879) dans sa théorie de l'électromagnétisme. Le champ électromagnétique de Maxwell était porté par un milieu matériel, identifié à l'éther luminifère de Huygens. En 1876, il écrivit: En parlant de l'énergie du champ, je souhaite être compris au sens littéral. Toute énergie est identique à une énergie mécanique, qu'elle existe sous forme de mouvement ou sous celle d'élasticité, ou sous toute autre forme. L'énergie qui intervient dans les phénomènes électromagnétiques est une énergie mécanique. La seule question est: où réside-t-elle? (extrait de The Scientific Papers of James Clerk Maxwell, 1890, vol. 1, p. 564. W. D. Niven, editor. Dover Publications, cité dans Sneaking Up On Einstein, trad. A. Boudet).

Dans le cadre de cette Physique Classique, la notion d'éther ne faisait que permettre aux esprits d'avoir une représentation des forces à distance et de la propagation de la lumière. Mais elle n'était absolument pas prise en compte dans les équations. Pourtant certains se sont demandé comment se comportait cet éther et s'il était possible de le mettre en évidence.

Afin de mettre en évidence un éventuel vent d'éther dû au déplacement de la Terre dans l'espace absolu, Albert Michelson et Edward Morley ont tenté de mettre en évidence la différence de vitesse de la lumière (supposée transportée par l'éther) pour des déplacements différents de la Terre, à savoir pour deux directions perpendiculaires et à deux périodes espacées de 6 mois.

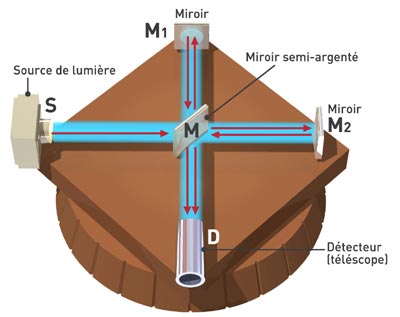

Dans ce but, Michelson conçut un appareil entièrement nouveau qui porte aujourd’hui son nom, l’interféromètre de Michelson.

Schéma de l'interféromètre de l'expérience de Michelson

Merci à © SCÉRÉN -CNDP. Créé en mars 2005 - Tous droits réservés. Limitation à l'usage non commercial, privé ou scolaire.

La source de lumière S envoie un faisceau sur un miroir M semi-réfléchissant placé au centre du dispositif. Le rôle d'un tel miroir (lame séparatrice) est de séparer le faisceau lumineux incident en deux faisceaux. L'un traverse la lame et continue vers le miroir M2. L'autre est réfléchi sur M et envoyé vers le miroir M1. M1 et M2 sont placés à la même distance de la lame M. Les miroirs M1 et M2 renvoient les faisceaux vers M qui les transmet ensemble vers le détecteur D. D reçoit la combinaison des deux faisceaux. Les temps pour parcourir les deux trajets sont distincts, ce qui produit des franges d'interférence.

La figure d’interférence est d'abord enregistrée dans la position où l’interféromètre sur Terre se déplace dans l'espace le long de la direction S-M. Ensuite, on fait tourner l'appareil de 90° et on examine si les interférences ont été modifiées.

Michelson et Morley ont refait plusieurs fois l'expérience dans des conditions différentes de 1881 à 1887, incluant des mesures à 6 mois d'intervalle. Dans tous les cas, aucune modification des interférences n'a été constatée.

George Gabriel Stokes (physicien britannique, 1819 - 1903), qui avait étudié la dynamique des fluides, était d'avis que l'éther est immobile par rapport à la Terre tandis que Fresnel pensait que l'éther est immobile dans le vide de l'espace et mobile par rapport à la Terre. Pour en comprendre l'enjeu, imaginons une journée sans un souffle d'air. Nous ne sentons pas l'air car il est immobile. Mais il est immobile seulement pour une personne immobile sur la Terre. Si nous nous déplaçons en vélo, nous sentons l'air nous fouetter le visage. De même, dans le cas où l'éther est immobile par rapport à la Terre, on ne peut pas le détecter. Par contre s'il est lié à un autre espace que la Terre, un espace absolu de l'Univers, la Terre devrait "sentir" le vent de l'éther en se déplaçant dans cet espace. Aussi des expériences ont-elles été menées pour tenter de mettre en évidence le vent d'éther sur Terre.

Si la lumière est une onde d'éther qui se propage dans le vide absolu, sa vitesse ressentie (mesurée) sur la Terre devrait varier selon la direction du déplacement de la Terre sur son orbite. Elle devrait être différente à 6 mois d'intervalle, lorsque les déplacements se font en sens opposés. Elle devrait également être différente si on la mesure dans la direction du déplacement sur l'orbite (est-ouest), ou dans la direction perpendiculaire (nord-sud).

De telles mesures ont été effectuées entre 1881 et 1887 par Albert Michelson (physicien américain né en Prusse, 1852-1931, prix Nobel de physique en 1907), d'abord seul, puis en association avec Edward Morley (chimiste étasunien, 1838 – 1923). Il n'est pas possible de mesurer directement les vitesses avec une précision suffisante. C'est pourquoi ils ont utilisé un interféromètre de leur fabrication qui met en évidence non pas les vitesses elles-mêmes, mais leurs différences, qui se manifestent par des franges d'interférence (voir le phénomène des interférences de lumière dans l'article Matière et rayonnements).

Dans toutes leurs expériences, Michelson et Morley (M-M) ne constatèrent aucune modification des franges d'interférence, donc aucune manifestation d'un vent d'éther. Les deux chercheurs en conclurent que s'il y a un mouvement relatif entre la Terre et l'éther luminifère, il doit être petit (c'est-à-dire en dessous des limites de précision du dispositif).

Remarquez qu'ils n'affirmèrent pas que l'éther n'existait pas. Les conclusions de cette expérience sont seulement que l'éther ne se manifeste pas DANS LES CONDITIONS DE L’EXPÉRIENCE. La conclusion stricte est que la vitesse de la lumière détectée sur Terre est la même dans toutes les directions et à tout moment, dans les limites de précision de l'appareillage.

Actuellement, l'expérience M-M est généralement présentée comme étant la preuve irréfutable de l'absence d'éther, alors qu'il ne s'agit que d'une de ses interprétations possibles. C'est un bel exemple de la façon dont des conclusions strictes sont remplacées par des interprétations hypothétiques qui sont présentées comme étant des conclusions logiques. Cela n'est pas fait intentionnellement, mais c'est la marque que les esprits sont enfermés dans des cadres de pensée qui les empêchent d'envisager les autres interprétations.

En effet, à l'époque de M-M, il était difficile d'envisager l'absence d'éther. En conséquence, il y eut des débats et des controverses importantes pour discuter des raisons possibles de l'absence de manifestation de l'éther dans les expériences M-M, qui ont donné naissance à plusieurs interprétations possibles. Certains scientifiques, tel Ernst Mach (physicien autrichien, 1838 - 1916) ont effectivement opté pour abandonner l'éther.

D'autres conservèrent l'hypothèse que l'éther existe, mais l'expérience M-M ne le mettait pas en évidence pour différentes raisons à examiner, par exemple si l'éther est lié à la Terre. Partisan de l'éther, le physicien irlandais George Francis Fitzgerald fit la proposition que les objets, qui sont imprégnés d'éther, subissent une contraction physique dans le sens de leur mouvement. À cause de cette contraction, le bras de l'interféromètre dans le sens du mouvement est raccourci et compenserait exactement la différence de vitesse de la lumière dans l'éther. Mais on s'aperçut plus tard que cette hypothèse n'était pas valide, car la vitesse de l'interféromètre devrait changer toutes les 12 heures.

Cette idée a été reprise et développée par Hendrik Antoon Lorentz (physicien hollandais, 1853 - 1928, prix Nobel de physique 1906). Il l'a rendue cohérente en la complétant par un phénomène d'allongement du temps. Les formules de contraction des longueurs et de dilatation du temps sont nommées formules de transformation de Lorentz. Les formules de Lorentz sont en accord avec la présence de l'éther. Je ne peux pas faire autrement que considérer l'éther, vraisemblablement le siège d'un champ électromagnétique avec son énergie et ses vibrations, comme investi d'une certaine substantialité, quelque différent qu'il soit de toute matière ordinaire. (H. Lorentz, 1906).

Plus proche de nous dans le temps, le physicien britannique Harold Aspden (1927 - 2011) affirma que l'éther qui nous entoure est un éther localisé attaché à la Terre.

Lors d’un discours en 1944 à Florence en Italie, le physicien allemand Max Planck (1858 - 1947), celui qui a introduit la notion de quantum en 1900, exprima sa conviction de l'existence d'un éther:

En tant qu’homme qui a consacré toute sa vie à la science la plus lucide et à l’étude de la matière, je peux vous dire ceci en conclusion de mes recherches sur les atomes: Il n’y a pas de matière comme telle. Toute la matière est originaire et n’existe que par la vertu d’une force qui cause les particules d’un atome à vibrer et qui soutient tout ce système atomique ensemble. Nous devons supposer derrière cette force l’existence d’un esprit conscient et intelligent. Cet esprit est la matrice de toute matière. (Max Planck, La nature de la matière, discours à Florence, 1944; archives de l’histoire de Max Plank, rep. 11, 1797)

Le flou dérangeant qui alimentait les controverses sur la mise en évidence de l'éther provient du fait que les fervents comme les opposants se représentaient l'éther comme un fluide matériel qui serait nécessaire comme milieu de propagation des ondes électromagnétiques. Il serait donc une substance, analogue à l'air ou à l'eau, qui obéirait aux lois de la matière et devrait donc présenter les caractéristiques de la matière fluide, avec ses courants, sa vitesse, sa pression, son inertie, sa résistance, son élasticité, sa rigidité, etc.

Mais cette représentation conduit à des incongruités, voire des incompatibilités théoriques. L'onde électromagnétique vibre transversalement, de la même façon qu'une vague dans l'eau. L'ondulation se propage parce que les molécules en mouvement ENTRAINENT (tirent) leurs voisines par une force de rappel qui détermine la vitesse de propagation (voir article Matière et rayonnements). Dans le cas de la lumière, la vitesse est très élevée, et cette force de rappel devrait être très grande. L'éther serait alors plus rigide que l'acier, donc n'aurait rien d'un fluide. D'un autre côté, puisque les planètes se meuvent dans l'espace à travers lui sans interférence décelable, l'éther doit être très mou, comme un gaz très raréfié. Il y a donc une contradiction.

La raison en est que considérer l'éther comme un fluide matériel est une supposition erronée, une idée préconçue qui n'a pas lieu d'être. Car, selon Einstein, cet éther ne doit cependant pas être conçu comme étant doué de la propriété qui caractérise les milieux pondérables, c'est-à-dire comme constitué de parties pouvant être suivies dans le temps: la notion de mouvement ne doit pas lui être appliquée. (Albert Einstein, L’éther et la théorie de la Relativité Générale, 1928, Leiden Lecture, traduction Maurice Solovine, Éd. Gauthier-Villars)

Autrement dit, l'éther ne peut pas être considéré comme un fluide matériel dont le mouvement pourrait être mis en évidence par la mesure de la vitesse de la lumière. Rien n'impose que l'éther ait les qualités de la matière. Si on se laisse inspirer par les enseignements traditionnels, il est dit, bien au contraire, que la matière nait de l'éther, mais l'éther n'est pas la matière. Il est au-delà de la matière, au-delà de toute perception sensorielle et il reste invisible à nos appareils. On ne peut que flairer les parfums qui s'en échappent parfois. On peut aussi l'appréhender par l'expérience mystique.Lorsque Einstein posa les principes de la Relativité Restreinte (connue à l'étranger sous l’appellation de relativité spéciale) dans un article en 1905, il reprit les formules de Lorentz, mais il donna un autre sens au temps et à l'espace. Il les érigea en principes universels non pas absolus, mais relatifs. Autrement dit, il n'existe plus de temps absolu, le nôtre, mais des temps qui sont différents pour chaque observateur. Il n'existe plus d'espace absolu, mais des espaces relatifs à chaque observateur. Einstein inventa le concept d'un espace-temps à 4 dimensions, dans lequel les 3 coordonnées d'espace et celle de temps jouent un rôle quasi-symétrique.

Or puisque l'éther était attaché à l'espace absolu et que l'espace absolu avait disparu, l'éther n'avait de fait plus d'existence. D'ailleurs, n'apparaissant nulle part dans les équations, il n'était même pas utile. Dans cet article de 1905, Einstein écrit: L'introduction d'un éther lumineux se révèle superflue par le fait que notre vision développée ici ne requiert aucun espace absolu au repos doué de propriétés particulières (A. Einstein, Zur Elektrodynamik bewegter Körper, Annalen der Physik, 1905, 17, 891-921)

Les physiciens eurent beaucoup de mal à accepter cette idée. Ils avaient aussi de la difficulté à saisir le sens de la relativité restreinte. C'est la notion d'espace absolu qui est abandonnée. Pourquoi éliminer l'éther lui-même? Einstein fut amené à le réintroduire.

L'abandon de l'éther par Einstein le dérangeait car elle ne concordait pas avec sa conviction profonde. Poursuivant ses raisonnements, il étudia des systèmes en mouvement accéléré. Dans ses calculs, il inclut les forces de la gravitation universelle. Aidé de deux mathématiciens, David Hilbert et Marcel Grossmann, il en déduisit les équations de la Relativité Générale qu'il publia en 1916 (A. Einstein, Die Grundlage der allgemeinen Relativitätstheorie, Annalen der Physik, 1916, 49, 769).

Dans le cadre de la Relativité Générale, l'espace est texturé par un milieu continu abstrait (le champ électromagnétique), sans support matériel bien qu'il soit doué de propriétés physiques comme la faculté de se déformer. Aussi, Einstein le considéra-t-il comme l'éther, qu'il réintroduisit dans sa vision de l'espace-temps. Il l'indiqua clairement à une conférence qu’il prononça à l’université de Leyde le 5 mai 1920:

Le point de vue qu'on pouvait, au premier abord, adopter en face de cet état de choses [les conclusions de la relativité

restreinte] semblait être le suivant: l'éther n'existe point du tout [...]

Une réflexion plus attentive nous apprend pourtant que cette négation de l'éther n'est pas nécessairement exigée par le principe de la relativité restreinte.

On peut admettre l'existence de l'éther, mais il faut alors renoncer à lui attribuer un état de mouvement déterminé, c'est-à-dire qu'il faut le dépouiller par l'abstraction de son dernier caractère mécanique que Lorentz lui a encore laissé. [...]

[D'après la relativité générale], la notion de l'éther a de nouveau acquis un contenu précis, contenu certes qui diffère notablement de celui de l'éther de la théorie ondulatoire mécanique de la lumière. [...]

En résumé, nous pouvons dire:

Selon la théorie de la relativité générale, un espace sans éther est inconcevable, car non seulement la propagation de la lumière y serait impossible, mais il n'y aurait même aucune possibilité d'existence pour les règles et les horloges et par conséquent aussi pour les distances spatio-temporelles dans le sens de la physique.

Albert Einstein, L’éther et la théorie de la Relativité Générale, 1928, Leiden Lecture, traduction Maurice Solovine, Éd. Gauthier-Villars

À cause du questionnement non résolu sur l'existence d'un éther, des scientifiques tentèrent de reproduire l'expérience de Michelson et Morley avec des appareils plus précis que les leurs.

C'est le cas de Ernest W. Silvertooth (1916 - 2000), un états-unien qui a effectué ses recherches avec le soutien de la Defense Advanced Research Projects Agency. Il affirma que le type d'interféromètre de M-M ne peut pas mettre en évidence le changement de vitesse de la lumière car il est compensé par le changement de sa longueur d"onde. Il refit l'expérience plusieurs fois entre 1986 et 1992 en mettant au point un autre type d'interféromètre qui utilise des ondes stationnaires.

Contrairement à l'appareil de M-M, celui de Silvertooth afficha clairement un déplacement des interférences. Il l’interpréta comme la preuve de l'existence d'un éther dans lequel la Terre se déplacerait à la vitesse de 378 km/s, tout au moins le jour de la mesure.

Bien que certains auteurs modernes s'appuient sur les publications de Silvertooth pour argumenter l'existence de ce fluide universel (il y a d'autres arguments plus solides), des expériences ultérieures minutieuses réalisées dans les mêmes conditions avec le même type d'appareil ont confirmé le déplacement des franges, mais elles suggèrent que le déplacement des franges serait dû aux variations de température s'exerçant sur les instruments et non au vent d'éther. (Doug Marett, A Replication of the Silvertooth Experiment)

Sources: dans Wikipédia, Relativité générale; Éther; Controverse sur la paternité de la relativité; Experimental Detection of the Ether (pdf ICI), E.W. Silvertooth, 1986, Spec. Sci Tech. Vol.10 No.1 p.3-11; Motion through the ether (pdf ICI), E.W. Silvertooth, Electronics and Wirelessworld, 1989, 437; A Replication of the Silvertooth Experiment, (pdf ICI) Doug Marett, 2012, Conspiracy of light

À la suite des débats sur l'éther, dans le cadre des développements de la mécanique quantique naissante, on chercha à clarifier les théories en distinguant les concepts qui étaient pris en compte dans la théorie et ceux qui lui étaient surajoutés, donc superflus. C'est ainsi que le concept d'éther fut considéré comme inutile et fut éliminé dans les formalismes de la Relativité Restreinte et de la Physique Quantique. Dès ce moment, l'espace fut décrit comme vide.

L'idée que l'espace est vide nous ramène directement à la vision de notre espace quotidien. Nous voyons des terrains vides sur lesquels on bâtit des maisons. Lorsque nous emménageons dans une nouvelle maison, les pièces sont complètement vides, et nous y disposons les meubles à notre guise.

Les "meubles" de l'espace sont des corps solides aussi petits que des particules, des atomes, des molécules, isolés ou assemblés en gaz, ou aussi énormes que les planètes et les étoiles. Ils nous semblent placés dans le grand vide cosmique. Celui-ci est infini, les murs et le sol de la maison ont disparu.

Tous ces objets se déplacent et interagissent dans le vide. Ils flottent dans l'espace comme le font des poussières dans l'air, ou des objets légers dans l'eau. Sauf que dans l'espace, justement, on considère qu'il n'y a pas de fluide. À moins qu'il y ait l'éther?

Les objets du cosmos peuvent interagir en s'attirant et en se repoussant. Ils subissent les forces créées par les autres objets. Ce sont des forces électriques et des forces de gravité.

Les forces électriques s'exercent entre particules chargées électriquement. Le cosmos en contient beaucoup, telles que les électrons et les protons. Les atomes sont composés d'électrons et de protons, et tout corps de matière est composé d'atomes. Donc tout corps est susceptible d'exercer des forces électriques sur un autre.

Les forces de gravité sont surtout sensibles entre les planètes et les galaxies, c'est-à-dire entre des masses importantes. Mais tout objet possédant une masse, même un atome, exerce une telle influence et en subit de la part des autres masses.

Pour décrire ces forces d'attraction et de répulsion, les théories de la physique emploient le concept de champ. Ce concept n'est pas trivial, car nous faisons naturellement l'expérience des forces et des mouvements d'énergie, mais pas celle des champs. C'est d'ailleurs à partir de l'expérience des forces que les physiciens ont élaboré leur concept de champ. Dans le premier article de cette série, j'ai expliqué comment était apparu le concept de champ au 18e siècle avec le physicien Michael Faraday. J'expose brièvement ici de quoi il s'agit.

Pensez à une balle que vous lancez en l'air et qui retombe sous l'effet de son poids. Ce que nous constatons avec nos sens et avec nos appareils de mesure, c'est que la balle est attirée vers la Terre par une force. C'est la force de gravité.

Si on s'avise de mesurer cette force avec des dispositifs appropriés, on constate qu'elle est d'autant plus grande que la balle est plus lourde, autrement dit qu'elle a une plus grande masse M. Elle est même proportionnelle à cette masse. Si on place une balle plus légère m, la force (le poids) sera plus petite. On peut donc imaginer qu'il existe une sorte d'influence qui est en place même en l'absence des balles, qui est prête à les retenir et les ramener à terre quand on les place à cet endroit. C'est le champ de gravitation g.

Le champ de gravitation a été étudié superbement par Newton. On peut très bien imaginer, comme il le fit, que le champ g est constitué d'une substance invisible, l'éther, qui remplit l'espace et exerce son influence sur la balle. L'éther pourrait transmettre l'influence de la Terre vers la balle. Cela expliquerait qu'il y ait une influence à grande distance entre les planètes.

Que l'éther soit une réalité ou non, la notion de champ ne s'en occupe pas. Le champ est une entité abstraite.

Mathématiquement, on peut écrire que la force de gravitation F sur une masse M est proportionnelle à M et égale à M x g

g est la valeur du champ de gravitation. Elle est variable en chaque point q de l'espace et en chaque instant t: g=g(q, t).

La force de gravitation est orientée, car elle est dirigée vers la Terre, mais cette orientation est différente d'un endroit à un autre. À un instant donné, la valeur du champ de gravitation est également différente d'un endroit à un autre. Pour décrire le champ, on peut donner une cartographie de ses valeurs et de ses orientations en tous les points de l'espace.

On peut faire l'analogie avec une carte météo des vents. En météo, la direction du vent est orientée. La direction et la force du vent aujourd'hui est différente à Lyon, à Bruxelles, à Montréal ou à Abidjan. On peut indiquer leurs valeurs en chaque point d'un territoire sur une carte. Les grandeurs comme celles la force du vent et de la gravité, qui ont une direction, sont dites vectorielles. On doit donner trois valeurs pour les définir, qui sont leurs composantes dans un repère à trois dimensions (voir article Images fractales).

La carte météo donne aussi les valeurs des températures. Elles n'ont pas de direction, mais seulement une valeur numérique. On dit qu'il s'agit d'une grandeur scalaire, c'est-à-dire répartie sur une échelle de valeurs (du latin scala = échelle). De la même façon, il existe des champs scalaires.

Il est souvent inutile de préciser point par point les valeurs du champ. Il suffit que l'on dispose d'une formule mathématique qui permette de les calculer en chacun des points. Une telle formule existe chaque fois qu'on connait la loi physique qui régit le champ. C'est le cas pour les forces de gravitation et pour les forces électromagnétiques. Prenons l'exemple des forces électromagnétiques.

Si vous placez deux particules A et B chargées dans l'espace, par exemple des électrons ou des protons, elles exercent une force électrique mutuelle sur chacune d'elles. Cette force est proportionnelle à leurs charges. Elle décroit avec la distance.

Note: La lecture des formules n'est pas indispensable. Elles sont données seulement pour ceux pour qui cela peut constituer des repères lisibles.

.

où qA et qB sont les charges électriques, d la distance entre les particules et k un facteur de proportionnalité.

À cause de cette proportionnalité, on peut dire que l'une des particules, par exemple B, crée un champ de force EB et que la deuxième, A, est placée dans ce champ et soumise à son influence.

.

On a donc défini un champ de force électrique en tout point de l'espace, produit par une particule.

L'introduction de la notion de champ est une astuce mathématique pour décrire la valeur de la force qui s'exerce sur toute autre particule. On peut calculer de même le champ créé par un ensemble de particules. Dans la logique originale de la physique classique, ce sont les charges présentes qui créent le champ électrique. En leur absence, il n'y a pas de champ.

Le champ électrique est un champ vectoriel. Il peut être calculé à partir d'un champ scalaire associé, le potentiel électrostatique.

Lorsque les particules bougent, elles créent en plus un champ magnétique. Les champs magnétiques et électriques sont associés en un champ électromagnétique qui se propage par ondes. Ainsi, les ondes électromagnétiques sont des champs, donc des entités mathématiques abstraites. Elles deviennent substantielles lorsqu'elles rencontrent de la matière électrisée et interagissent avec elle: antenne, capteur d'un appareil photo ou cellule de l’œil par exemple.

Revenant à notre description de l'Univers, nous pouvons maintenant préciser que l'Univers est rempli d'une part de matière, d'autre part d'une abondance de champs, électromagnétiques et gravitationnels, qui se propagent dans l'espace.

Tandis que les champs de la physique classique n'existent qu'en présence de charges, ils ont acquis une existence autonome en physique quantique. C'est un postulat, une hypothèse de départ. Selon le modèle standard, le champ électromagnétique est une entité qui existe dans l'espace même en l'absence de charges. Autrement dit, les physiciens imaginent que l'espace est primordialement rempli de champs, sans se soucier de la nature de leurs causes ou de leurs sources. Comme ces champs sont associés à une énergie, l'espace est devenu un vaste réservoir d'énergie.

Pour soutenir cette hypothèse, les physiciens s'appuient sur les modèles de la cosmologie. Le scénario mathématique (et spéculatif) de la création de l'Univers majoritairement admis comme modèle standard prévoit qu'il a commencé par un événement appelé Big Bang, suivi d'une ère brève (10-43 s) où toutes les énergies étaient manifestées seulement sous la forme de rayonnements d'un type unique. Puis ce type de rayonnement s'est différencié progressivement jusqu'à 10-11 s en 4 types correspondant aux quatre forces fondamentales: force de gravitation, force nucléaire forte, force électrofaible, force électromagnétique. Puis après expansion et refroidissement, des particules avec masse se sont formées, tels l'électron puis le proton vers 10-5 s.

Pourtant, supposer l'existence d'un champ autonome préalable conduit parfois à des incongruités. Par exemple, un électron exerce des forces sur les autres particules représentées par le champ de l'électron, et il n'exerce pas de force sur lui-même. Mais si l'on donne au champ de l'électron le statut d'existence préalable autonome, alors il doit rétro-agir sur l'électron lui-même comme il agit sur n'importe quelle particule chargée. Or le calcul montre que l'énergie d'interaction de l'électron sur lui-même est infinie. Par définition, l'électron aurait donc une énergie infinie, ce qui est conceptuellement et physiquement absurde.

Aussi les physiciens (plus précisément le physicien autrichien Wolfgang Pauli, 1900-1958) ont-ils inventé un stratagème pour que l'électron n'agisse pas sur lui-même: ils l'ont habillé d'une nuée de photons faisant écran !!! Nous verrons dans d'autres articles que certains physiciens ont élaboré des modèles d'électrons aux dimensions finies (et non réduites à un point), qui résolvent ce problème.

Cela montre que plus la physique devient abstraite, plus les hypothèses de départ s'éloignent des faits expérimentaux, plus il faut ajouter des hypothèses supplémentaires compliquées qui viennent contrebalancer ou corriger les premières. En définitive, on arrive à un échafaudage de calculs qui permettent des prévisions pratiques vérifiables, mais qui nous laissent interrogatifs sur leur rapport avec la réalité.

Alors que la mécanique quantique des débuts considère que l'espace est vide, une autre branche qui se développe plus tard vers 1930, la Mécanique Quantique Relativiste ou Théorie Quantique des Champs va décrire un espace peuplé de champs de forces, particulièrement de champs électromagnétiques, porteurs d'une énergie colossale.

Au moment où la Mécanique Quantique s'élaborait (voir article Concepts de la Physique Quantique), la théorie de la Relativité Restreinte due à Einstein était acceptée comme un principe fondamental. Mais les deux théories sont bâties sur des concepts très différents qui sont difficiles à concilier. Aussi, très vite, les physiciens se sont demandé comment ils pouvaient introduire les concepts de la Relativité Restreinte dans la Mécanique Quantique, et construire une Mécanique Quantique Relativiste.

Ils se heurtèrent à deux difficultés. La première provient de la place du paramètre temps qui intervient dans la description des mouvements des particules. En Mécanique Quantique, le temps a son sens habituel. En Relativité, il est considéré comme une coordonnée de l'espace-temps et se transforme par changement de repère selon les formules de Lorentz. Selon ces formules, l'influence d'une particule sur une autre n'est pas immédiate, mais voyage à la vitesse de la lumière.

Le deuxième difficulté résulte de l'équivalence de la masse et de l'énergie en Relativité, exprimée par la fameuse équation E = mc2. Elle implique que de l'énergie pure de l'espace peut se transformer en des particules de masse, et réciproquement. Cela se produit dans les réactions de désintégration nucléaire. Autrement dit des particules peuvent naitre et disparaitre. La théorie quantique relativiste doit donc intégrer une variation du nombre de particules, tout en gardant constante l'énergie totale.

Pour établir les lois d'une Physique Quantique Relativiste et les équations qui les régissent, les physiciens ne suivent pas une déduction logique et mathématique. Il faut les deviner, puis vérifier qu'elles se confondent avec les lois déjà connues lorsqu'on se place dans les conditions non-relativistes, calculer les rayonnements émis par les atomes et particules et vérifier que les valeurs trouvées sont conformes aux résultats expérimentaux. Pour deviner ces équations, les physiciens sont guidés par des principes: les symétries de l'univers, les lois de conservation de grandeurs comme l'énergie, et le principe de correspondance entre les équations de la physique classique et celles de la physique quantique.

Nombreux sont les physiciens de cette époque qui se sont attelés à la tache, et ont proposé des équations diverses, plus ou moins satisfaisantes. Elles expliquaient certains phénomènes physiques, mais étaient incomplètes ou contradictoires sur d'autres aspects. La contribution la plus remarquée et la plus puissante fut celle de Paul A.M. Dirac (physicien britannique, 1902 - 1984). Par les apports successifs des physiciens, une théorie cohérente émergea. (voir les détails en annexe)

Dans cette théorie, on considère que l'espace est rempli de vibrations ou oscillateurs (voir en annexe) dont l'énergie est quantifiée, c'est-à-dire qu'elle ne peut pas prendre toutes les valeurs, mais seulement des valeurs étagées, multiples de leur énergie fondamentale. Ces fréquences et énergies fondamentales s'étalent des plus petites (nulles) aux plus grandes (infinies).

Si f est la fréquence fondamentale de l'oscillateur, son énergie prend des valeurs multiples de hf où h est la constante de Planck, auxquelles il faut ajouter une énergie résiduelle 1/2 hf.

Pour décrire les multiples niveaux d'énergie d'un oscillateur de fréquence f, la théorie quantique des champs représente l'oscillateur comme s'il était un ensemble de corpuscules identiques (des photons virtuels) possédant une énergie hf. Le niveau fondamental est représenté par l'absence de photon virtuel. Lorsque le niveau d'énergie de l'oscillateur augmente, il est représenté par un nombre croissant de photons virtuels.

Un photon virtuel est l'élément mathématique de base. Les photons ne sont pas physiques, ils ne peuvent pas être détectés physiquement. Ce sont des êtres mathématiques.

L'image de l'espace a donc changé. Nous voici en présence d'une mer de photons virtuels.

Le néant est peuplé de particules virtuelles.

Merci à Jean-François Colonna - CMAP/ CNRS/ École polytechnique

Dans cette mer de photons, plaçons une particule chargée électriquement, par exemple un atome. Comment réagit-il? Il peut rester dans un état stable pendant un moment, mais il arrive que son énergie passe à un niveau supérieur. Dans le formalisme de la théorie quantique du champ, cette transition est décrite comme le transfert d'un nombre précis de photons virtuels du champ vers l'atome qui les absorbe.

Dans la théorie quantique du champ, toutes les interactions sont formalisées de cette manière, par des échanges de corpuscules virtuels. Par exemple lorsque deux électrons se rencontrent et que leurs trajectoires sont déviées, cela correspond au transfert d'un photon virtuel de l'un à l'autre.

Selon la physique quantique, relativiste ou non, le niveau d'énergie d'un oscillateur (donc sa contenance en photons) est fluctuant. Elle ne peut que calculer la probabilité qu'il soit à un niveau ou à un autre. C'est la conséquence d'une des lois fondamentales de la physique quantique, le principe d'indétermination d'Heisenberg.

Cette loi stipule qu'il est impossible de déterminer simultanément l'énergie précise d'une particule et l'instant précis où on la mesure (voir Concepts de la physique quantique). Par exemple, s'il s'avère que l'énergie de la particule est bien déterminée, on ne peut pas connaitre l'instant précis où l'énergie prend cette valeur. Autrement dit, elle conserve cette énergie moyenne pendant un temps infini, et la particule est stable pendant tout ce temps.

Inversement, si une particule apparait dans un intervalle de temps très bref bien défini, alors son énergie reste floue et peut prendre des valeurs dans un ample intervalle des plus basses aux plus hautes énergies.

C'est justement le cas des oscillateurs du champ quantique, qui fourmillent de façon très brève. Ils ont donc une probabilité importante d'avoir une haute énergie. Dans ce cas, cette énergie peut être transformée en masse selon le principe de Relativité Restreinte qui stipule l'équivalence de l'énergie et de la masse selon la formule E = mc2. C'est pourquoi les photons peuvent donner naissance à des particules de masse comme l'électron. On passe de la non-matière à la matière.

Toutefois, l'électron possède non seulement une masse, mais aussi une charge électrique qui ne peut pas être créée de rien. Si l'on part d'un champ sans charge électrique, on ne peut pas créer une charge négative sans créer en même temps un charge positive, afin que la globalité reste électriquement neutre. La création d'un électron doit donc être accompagnée de la création simultanée d'une particule chargée de la même quantité positive (un positron). C'est ce qu'on appelle une création de paires de particules, sous-entendu, de charges opposées.

Lorsque de telles particules se rencontrent à nouveau, elles s'annihilent et disparaissent en restituant leur énergie au fond énergétique du champ. C'est pourquoi leur existence est très brève.

Par ce processus, le champ de photons qui remplit l'Univers peut donner naissance à un nombre incalculable de particules de matière plus ou moins éphémères. On est amené à décrire l'Univers comme une vaste mer fourmillante de photons où d'innombrables particules apparaissent et disparaissent très brièvement. C'est ce que les physiciens nomment les fluctuations de l'énergie et du nombre de particules du vide.

Cette vision proposée par la théorie quantique des champs a complètement modifié l'image que l'on avait d'un univers vide. Le monde y est décrit par des champs d'énergie. En chaque point de l'espace vide, tout est en perpétuelle création et dissolution. Il y a des mouvements perpétuels d'énergie dans une vaste matrice cosmique. Les particules matérielles sont les émergences de ces paquets d'énergie.

"Le vide fluctue d'une manière aléatoire entre l'être et le non-être." (Heinz Pagels, physicien, The cosmic code, Bantam Books, 1983).

À partir de la théorie quantique des champs et de sa description d'un vide plein de photons virtuels, le physicien néerlandais Hendrick Casimir (1909 – 2000) a calculé en 1948 que si un tel gaz de photons existe, il devrait avoir des effets physiques mesurables dans certaines situations spéciales.

|  |

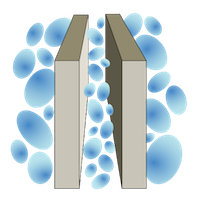

| Hendrick Casimir Merci à Wikipédia | Schéma du principe d'attraction de deux plaques métalliques proches dans le vide quantique, selon Casimir. La taille des bulles représente la longueur d'onde des photons Merci à Wikipédia |

Casimir (rien à voir avec le sympathique dinosaure de l'émission télévisée de l'Ile aux Enfants) imagine en pensée un dispositif comprenant deux plaques métalliques placées parallèlement dans l'espace vide. Lorsqu'il y a une seule plaque, elle est bombardée en permanence par des photons qui exercent un impact sur elle. Comme les impacts sont reçus des deux côtés, la plaque reste en équilibre et rien ne se passe.

Il en est de même pour deux plaques, sauf si on les rapproche très près l'une de l'autre. Dans ce cas, les faces qui se font face reçoivent moins de photons, à condition que leur distance n'excède pas quelques micromètres. Mathématiquement, on peut dire que si la distance entre les plaques est L, les photons de longueur d'onde supérieure à L sont exclus de l'espace intérieur (voir figure).

Les impacts sur les faces externes sont plus grands que ceux sur les faces internes. Il doit en résulter une pression qui tend à rapprocher les plaques. Elle est d'autant plus grande que les plaques sont proches.

Pour prouver la réalité de la force de Casimir, il fallait réaliser un dispositif expérimental suffisamment sensible pour la mesurer. Or la force en question est de l'ordre de 1 dix millionième de gramme. Cela a pu être mesuré seulement à partir de 1996, par Steven Lamoreaux (physicien étasunien) à l'université de Washington, avec des plaques distantes de quelques micromètres. Les résultats concordent avec la théorie à 5% près. Par la suite, quelques expériences effectuées avec un pendule de torsion ou avec un microscope à force atomique ont vérifié la grandeur de la force de Casimir avec encore plus de précision.

On a donc une confirmation de l'existence et de la valeur de la force d'attraction de Casimir. Mais cela ne prouve pas qu'elle tire son existence de la mer de photons du vide. Elle ne prouve pas la réalité de cette mer et de ses fluctuations.

En effet, il est tout à fait possible de calculer cette force au moyen d'autres théories qui ne font pas appel au vide lui-même, mais aux caractéristiques matérielles des plaques. Et on arrive à des valeurs semblables. Ces théories alternatives tiennent compte des mouvements fluctuants des atomes des plaques qui s'influencent mutuellement d'une plaque à l'autre (forces de Van der Waals).

Il est également possible de rendre compte de cette force en imaginant un espace cosmique rempli d'un éther non électromagnétique remplissant l'espace. Nous le décrirons dans d'autres articles.

Le fait que plusieurs théories, échafaudées sur des suppositions différentes, rendent compte de façon équivalente de résultats expérimentaux nous alerte sur le point suivant: une vérification expérimentale en accord avec une théorie ne prouve pas forcément la validité de la théorie. Rien n'empêche qu'une autre théorie, parfois plus vraisemblable, parfois encore non explorée, soit en accord avec les résultats expérimentaux.

Sources: The Casimir force: background, experiments, and applications, Steven K Lamoreaux, Reports on Progress in Physics, 2005, 68, 1; La force qui vient du vide, Astrid Lambrecht, La Recherche 376, 2004, 48; The Casimir Effect and the Quantum Vacuum, Robert L. Jaffe, Physical Review, 2005, D 72 (2); The Casimir Effect, A Comprehensive Exercise, Kyle Kingsbury, 2009

Les oscillateurs de l'espace sont équivalents à un gaz de photons. Pour comprendre comment ils se comportent en fonction de la température, comparons cette situation à un réservoir contenant un gaz de molécules.

Dans le cadre de la physique classique, selon la théorie cinétique des gaz, les molécules s'agitent dans tous les sens dans leur récipient, s'entrechoquent, échangent de l'énergie, repartent dans d'autres directions, etc. L'énergie de mouvement d'une molécule ou de tout autre corps est appelée énergie cinétique (du grec kinéticos = mouvement, comme dans cinématographe = image en mouvement).

Dans un gaz, les molécules ont chacune des trajectoires, des vitesses et des énergies cinétiques déterminées. Mais elles sont en si grand nombre qu'on ne peut pas les décrire individuellement. On ne peut décrire qu'une distribution statistique, calculer le nombre moyen de particules qui ont une énergie donnée et ceci pour toutes les valeurs prises par l'énergie (voir article Matière et Rayonnements), de zéro à l'infini.

Cette distribution varie avec la température. Plus on chauffe, plus les molécules s'agitent, plus elles ont de l'énergie cinétique. Cela est vrai non seulement dans un gaz, mais aussi dans un liquide comme l'eau ou dans un cristal. Dans un cristal, les atomes vibrent autour d'une position centrale dite "de repos". Plus on les chauffe, plus ils emmagasinent de l'énergie calorifique sous forme d'agitation moléculaire (voir article Géométrie cristalline).

Inversement, si on refroidit le gaz, l'eau ou le cristal, l'agitation moléculaire ralentit progressivement. Les physiciens se sont posé la question: si on continue à refroidir un corps matériel, y a-t-il un moment - une valeur de la température - où cette agitation atomique cesse? La thermodynamique classique répond oui. L'agitation cesse au zéro absolu, soit -273,15°C. C'est une température extrêmement basse, dont on peut se rapprocher expérimentalement, sans jamais toutefois pouvoir l'atteindre strictement.

Historiquement, la notion de zéro absolu est apparue avec les études de l'évolution des caractéristiques des gaz en fonction de la température. Les physiciens s'aperçurent qu'en refroidissant un gaz, sa pression diminuait de façon régulière. Ils ont tracé le graphique expérimental représentant la diminution de la pression en fonction de la température. On pouvait le formaliser par une équation mathématique. Puis, en prolongeant mathématiquement cette ligne jusqu'à la pression zéro, ils pouvaient lire que cela se produisait à une certaine température qu'ils ont qualifiée de zéro absolu.

D'autres physiciens s'intéressaient à la quantité de chaleur (l'énergie) qu'on doit transférer à un corps pour le chauffer d'une certaine quantité, qui est nommée chaleur spécifique. Inversement, pour le refroidir, par exemple d'un degré, on lui soutire une quantité de chaleur. Cette chaleur ou énergie spécifique varie avec la température et s'annule au zéro absolu.

C'est à partir de ces résultats que le physicien anglais William Thomson Lord Kelvin proposa en 1848 une échelle des températures, la température absolue T exprimée en degrés nommés plus tard de son nom degrés Kelvin. Le zéro de l'échelle est fixé au zéro absolu. Cette échelle est identique aux degrés Celsius auxquels on ajoute la valeur 273,15. L'intérêt de cette définition de la température est qu'elle est proportionnelle à l'énergie accumulée.

Dans le vide, les mouvements des molécules, atomes ou particules cessent au zéro absolu et l'énergie cinétique des molécules est donc nulle. Ainsi, selon la thermodynamique classique, l'énergie totale du vide est nulle au zéro absolu, qu'il soit ou non peuplé de molécules.

Or, en contradiction avec cette hypothèse, Albert Einstein et Otto Stern ont analysé en 1913 des mesures expérimentales concernant l'agitation des molécules et de l’absorption de chaleur par l'hydrogène en fonction de la température (Einige Argumente für die Annahme einer molekularen Agitation beim absoluten Nullpunkt, Annalen der Physik, 1913, 345, 3, 551–560, consultable dans ce site). Ils se sont aperçus que les résultats ne pouvaient pas s'expliquer correctement par la formule originale de Planck (voir article Concepts de la physique quantique) et qu'il fallait ajouter un terme correctif. Ils énoncèrent que: les résultats [expérimentaux] d'Eucken sur la chaleur spécifique de l'hydrogène rendent probable l'existence d'une énergie du point zéro égale à . Notons qu'ils n'ont pas fait appel à une quantification.

Cette énergie du point zéro est une agitation résiduelle qui subsiste dans les atomes et les molécules à la température du zéro absolu. Ils la nommèrent en allemand Nullpunktsenergie soit énergie du point zéro. Par la suite, en 1916, Walther Nerst (chimiste allemand, 1864 - 1941) affirma que l'univers était rempli de l'énergie du point zéro.

En physique quantique, on considère au départ un espace vide de molécules et d'atomes. Au zéro absolu, l'énergie est nulle.

Au contraire, dans le cadre de la physique quantique relativiste, le vide est rempli de champs électromagnétiques qui conservent une énergie résiduelle, même au zéro absolu (voir encadré L'énergie du vide quantique). Elle est appelée énergie du point zéro ou énergie de vide quantique du point zéro.

L'énergie du point zéro est l'énergie qui subsiste lorsque toute autre forme d'énergie a été enlevée.

Peut-on évaluer l'énergie totale en ajoutant les contributions de toutes les fréquences? Oui. Mais le résultat varie en fonction de la théorie utilisée pour faire le calcul. L'énergie totale du vide peut être finie ou infinie.

Dans une première approche de la théorie quantique des champs, les fréquences s'étalent des plus basses qui sont nulles, aux plus hautes qui sont infinies. Le calcul montre alors que l'énergie totale du point zéro est infinie.

Cela pose un gros problème. Si l'énergie la plus basse du champ est infinie, comment exprimer une énergie plus élevée?

C'est parce que les physiciens étaient gênés dans leurs calculs par cet infini qu'ils ont convenu d'attribuer à ce niveau la valeur zéro, un processus mathématique qu'ils ont nommé la renormalisation et dont ils ont précisé la procédure en 1948.

D'après eux, la justification tient dans le fait que l'énergie du point zéro n'est pas observable et n'a donc aucun sens physique. On ne peut observer et mesurer que des variations d'énergie par rapport à ce niveau de base et on ne s'occupe que de ces variations.

Cette définition est donc liée à ce qu'on sait observer. Mais qui sait? Il y a peut-être des phénomènes expérimentaux qui sont liés à cette mer d'énergie du point zéro, autres que ses fluctuations, et qui seraient donc observables. Nous explorerons cette question dans d'autres articles.

Max Planck a recherché des unités qui soient les plus naturelles possibles à partir des constantes fondamentales de la physique. Il les a présentées en mai 1899, avant sa théorie du rayonnement du corps noir (voir Concepts de la physique quantique). Voici quelques-unes de ces unités, celles qui nous sont utiles pour la compréhension des déductions sur l'énergie du vide.

La constante de Planck est un quantum d'action (une énergie x un temps). Elle est désignée par h. Dans sa forme réduite

= , elle vaut:

=1,055 ×10-34 Joule.s

Si G est la constante de la gravitation et c la vitesse de la lumière (299 792 458 m/s), la longueur de Planck s'en déduit:

Elle vaut lp = 1,62 x 10-35 m

Le temps de Planck est la durée que met un photon dans le vide pour parcourir la longueur de Planck soit lp/c. Il vaut

tp = 5,39 x 10-44 s, soit environ 10-43 s

La fréquence de Planck est son inverse, soit 1043 Hz.

Sources: Unités de Planck, Wikipédia; Formules de physique; La cosmologie quantique par Luxorion

La renormalisation n'empêche pas de tenter d'estimer la valeur de l'énergie du vide par des approches différentes.

Des physiciens ont estimé que les fréquences d'oscillations du vide ne pouvaient pas s'élever jusqu'à l'infini et qu'elles devaient avoir une limite supérieure. Cette limite est liée à l'indétermination d'Heisenberg, et à la constante de Planck.

En effet, puisqu'on ne peut pas définir précisément un objet simultanément dans sa position et sa vitesse, ou dans son énergie et son impulsion à cause de l'indétermination d'Heisenberg, il existe une sorte de longueur universelle qui constitue une limite inférieure de réalité, appelée la longueur de Planck. Cette longueur de Planck lp est extrêmement petite. Elle vaut 1,62 x 10-35 m. On la déduit de la constante de Planck h (voir les détails mathématiques dans l'encadré "Unités naturelles de Planck").

Selon les concepts de la physique quantique, les ondes électromagnétiques ont une longueur d'onde qui ne peut pas être inférieure à la longueur de Planck lp. En conséquence leur fréquence a une limite supérieure, la fréquence de Planck fp, qui vaut environ 1043 Hz. C'est par principe la fréquence maximum théorique des oscillateurs dans le vide.

Avec cette limite - un peu arbitraire - l'énergie du vide reste finie, quoique gigantesque. On la calcule dans un centimètre cube égale à 1091 kg/cm3.

Le vide quantique est exploré par la physique quantique à l'échelle de l'atome. Il prend en compte presque exclusivement les champs électromagnétiques. À l'autre extrémité de l'échelle de grandeur, la cosmologie étudie le vide cosmique. La cosmologie étudie les mouvements et l'évolution des étoiles et des galaxies.

Or ce sont les champs de gravitation qui sont la cause de l'attirance des planètes, des étoiles, et aussi des atomes à l'intérieur des étoiles, etc. Aussi les théories du vide cosmique prennent-elles essentiellement en compte les champs de gravitation.

En l'état actuel de la science, la théorie qui rend compte de l'évolution des corps cosmiques sous l'effet de la gravitation est la Relativité Générale d'Einstein. Mais l'équation générale fondamentale de cette théorie est trop complexe pour qu'on puisse la résoudre. On ne peut le faire mathématiquement que dans des cas particuliers simples. Aussi les cosmologistes ont-ils dû faire des hypothèses simplificatrices pour en tirer parti.

Ils considèrent que l'Univers est homogène. Cela signifie qu'il y a partout à peu près la même densité de matière. Cette densité reste constante dans le temps quelle que soit l'évolution de l'Univers. En réalité, l'Univers n'est pas homogène. Les étoiles sont rassemblées dans des galaxies, les galaxies dans des amas et des super-amas, et les super-amas dans des filaments (voir article Aspects géométriques et sonores de l'Univers). Les cosmologistes supposent aussi que l'Univers est isotrope, c'est-à-dire qu'il se présente de la même façon dans toutes les directions à partir de n'importe quel point de l'espace.

Avec ces simplifications, les équations peuvent être ré-écrites et résolues. C'est Alexandre Friedmann (physicien russe, 1888-1925) qui a proposé et fait ce calcul dans un article de 1922. Ses équations prédisent que l'univers est en expansion, ce qui sera vérifié par les déductions d'Edwin Hubble (astronome étasunien 1889 - 1953) en 1930.

De plus, les équations de Friedmann indiquent que cette expansion peut suivre 3 scénarios, selon la valeur de la densité de matière-énergie (homogène). Si cette valeur se situe en-dessous d'une valeur critique, l'univers s'étendra indéfiniment. Au dessus de cette valeur, sous l'effet de l'attraction gravitationnelle de cette masse-énergie, il se repliera sur lui-même au bout d'un certain temps. Entre les deux, pour la densité critique, on dit que l'univers est plat (mathématiquement parlant, car il n'est pas géométriquement plat dans l'espace à 3 dimensions). Au moment des équations de Friedmann dans les années 1920, la densité de matière connue semblait placer l'univers dans le cas de l'expansion éternelle.

Les équations prédisent aussi que la vitesse d'expansion baisse peu à peu. Or en 1998, des astronomes étasuniens (Saul Perlmutter, Brian Schmidt et Adam Riess, tous les trois prix Nobel de Physique en 2011), observant des explosions de certaines étoiles phares (des supernovae de type Ia) interprétèrent les mesures comme indiquant une phase d'accélération de l'expansion de l'Univers. Mais cela n'est pas compatible avec l'équation de la Relativité Générale. Toutefois, on peut ajuster cette équation pour qu'elle soit compatible en lui ajoutant arbitrairement un terme correctif.

Ce terme représente une énergie qui tempère la force de gravitation qui tend à rétrécir l'Univers. C'est l'énergie noire (à ne pas confondre avec la matière noire). Elle est ainsi appelée parce qu'on ne la détecte pas. On ne sait donc pas si elle existe vraiment. C'est seulement une supposition posée pour ajuster l'équation à une phase d'accélération de l'Univers.

Or il se trouve qu'Einstein avait déjà, dès 1917, ajouté ce terme correctif à son équation sous le nom de constante cosmologique. C'était une constante de l'Univers dont il ne connaissait pas la nature. Elle lui semblait nécessaire, non pas pour ajuster les mouvements de l'Univers à une accélération qui n'était pas envisagée, mais au contraire pour rendre compte d'un univers statique, comme on le supposait encore avant 1930. Puis il l'abandonna quand on sut que l'univers était en expansion.

Georges Lemaître (prêtre belge et astrophysicien, 1894 - 1966), le premier à évoquer la naissance de l'Univers à partir d'un point-source qu'on nommerait plus tard Big Bang, remarquait en 1933 que la constante cosmologique pouvait être considérée comme une force de pression exercée par un fluide, qui équilibrait la densité d'énergie. Elle est une énergie emplissant le vide.

Avec la mise en évidence des phases inflationnaires, c'est cette constante cosmologique qui revient sous le nom d'énergie noire. Actuellement, les cosmologues estiment que l'univers est composé de 5% de matière visible, de 23% de matière noire, et de 72% d'énergie noire, et que la densité d'énergie le place dans le scénario de la densité critique où il est mathématiquement plat.

Quelle est la nature de cette énergie noire? Se pourrait-il qu'elle s'identifie à l'énergie du point zéro? Pour le savoir, certains physiciens ont tenté d'évaluer sa valeur. Ils ont examiné les distances des galaxies éloignées qui correspondent aux phases inflationnaires, puis ils ont ajouté certaines hypothèses qui permettent d'attribuer des âges à ces galaxies. Dans ces conditions, la valeur estimée de l'énergie noire (constante cosmologique) est 10-29 g/cm3.

Elle est incroyablement inférieure à l'énergie quantique du point zéro telle que nous l'avons déterminée plus haut, 10-120 fois plus petite. Il n'est donc pas envisageable de les confondre. Les scientifiques sont interrogatifs devant cette différence.

Sources: The Cosmological Constant, Sean M. Carroll, Living Rev. Relativity, 4, (2001), 1

Ce désaccord est l'une des zones d'ombre qui subsistent dans le modèle standard du champ du vide. Même si celui-ci a permis de mettre en lumière que le vide était un grand réservoir d'énergie, et même s'il est en accord avec certains résultats expérimentaux à l'échelle atomique et sous-atomique, il laisse quelques insatisfactions. Il repose sur certaines hypothèses arbitraires, mais sont-elles réalistes ou justifiées? Et que penser de cette renormalisation qui semble seulement une accommodation?

À cause de ces grains de sable gênants, des modèles alternatifs ont été esquissés. Ils posent d'autres hypothèses. Les lois de la gravitation sont prises en compte et parfois modifiées. Les forces fondamentales pourraient être différentes des quatre habituellement retenues. L'Univers pourrait être statique. Et la quantification n'est peut-être pas nécessaire. Certains de ces modèles rendent même théoriquement possible l'extraction d'énergie du vide.

Nous en examinerons quelques-uns dans les prochains articles.

La première formulation d'une équation qui définit la fonction d'onde d'une particule relativiste dans un champ électromagnétique fut proposée en 1926 par Oskar Klein (physicien suédois, 1894 - 1977) et Walter Gordon (physicien allemand, 1893 - 1939). C'était une belle avancée théorique. Mais cette équation n'est valable que pour des particules d'hélicité (moment magnétique intrinsèque ou spin) nulle, donc pas pour des électrons dont le spin est 1/2 par exemple. D'autre part, les solutions trouvées correspondent pour une part à des réalités physiques et pour une autre part à des systèmes d'énergie négative absurdes.

Une autre approche très élégante a été élaborée par Paul Dirac en 1928 pour les particules de spin 1/2. Mais elle conduit également à des solutions où certaines particules ont des énergies négatives qui ne correspondent à rien de physique. Toutefois, c'est cette difficulté qui l'a conduit à inventer la notion d'antiparticule, qui sera reprise par la suite dans un contexte différent.

Auparavant, en 1926, Pascual Jordan (physicien allemand, 1902 - 1980), à la fin d'une étude sur la mécanique des matrices avec Werner Heisenberg et Max Born, esquissa une quantification d'un champ libre dans une cavité en utilisant le modèle d'une collection d'oscillateurs (voir annexe suivante).

En 1927, Paul Dirac (article intitulé La théorie quantique de l'émission et de l'absorption du rayonnement) quantifia l'interaction d'un champ électromagnétique et d'un atome en utilisant une méthode qui sera baptisée seconde quantification. C'étaient les prémisses de la théorie quantique des champs.

Dans la Théorie Quantique des Champs, ce n'est pas seulement l'énergie de la particule qui est quantifiée. Le champ électromagnétique dans laquelle elle se trouve plongée l'est aussi. Pour quantifier le champ, on le décrit comme un ensemble d'oscillateurs et on applique le processus de quantification à chacun des oscillateurs.

La théorie de Dirac présentait le défaut de ne pas être compatible avec la théorie de la Relativité Restreinte. Mais elle était féconde et fut étudiée en détail par de nombreux physiciens, et généralisée pour des systèmes et avec des formalismes divers.

Dans ces années de 1925 à 1955 environ, les physiciens étaient très passionnés, entretenaient des correspondances et discutaient de ces nouvelles théories dans des congrès nationaux et internationaux (les plus célèbres étant Solvay 1927 et Shelter Island 1947). La Théorie Quantique des Champs (TQC) s'est élaborée peu à peu, propulsée par le désir de résoudre ses incongruités et ses étrangetés.

Citons Paul Dirac lui-même, Werner Heisenberg (physicien allemand dont j'ai déjà parlé dans l'article précédent à propos de sa célèbre relation d'indétermination, 1901 - 1976), Pascual Jordan, Wolfgang Pauli, Hermann Weyl (mathématicien allemand, 1885 - 1955), Vladimir Fock (physicien russe, 1898 - 1974), Boris Podolsky (physicien russo-étasunien, 1896 - 1966), Enrico Fermi (physicien italo - étasunien, 1901 - 1954), Eugene Wigner (physicien hongrois, 1902 - 1995), Victor Weisskopf (physicien autrichien naturalisé étasunien, 1908 - 2002), Lev Landau (physicien russe, 1908 - 1968), Rudolf Peierls (physicien allemand, 1907 - 1995), Robert Oppenheimer (physicien étasunien, 1904 - 1967), Léon Rosenfeld (physicien belge, 1904 - 1974), Richard Feynman (physicien étasunien, 1918 - 1988), et encore d'autres.

Plus de détails, voir: Les débuts de la théorie quantique des champs, Olivier Darrigol, 1982, thèse de 3e cycle, consultable dans ce site.

En physique classique ou quantique, le mouvement des corps qui oscillent sont tous décrits par des formules analogues, que ces corps soient un poids qui se balance ou un atome qui vibre. On désigne ces corps vibrant sous le nom général d'oscillateur.

Merci à Wikipédia

Un exemple d'oscillateur à notre échelle macroscopique est un poids suspendu à un ressort. Lorsqu'il est au repos, nous pouvons repérer sa position, qui sera l'endroit de référence, la position zéro. Si nous tirons sur ce poids verticalement jusqu'à un autre endroit, que nous nommerons qM, nous lui communiquons une énergie, emmagasinée dans le ressort, qui n'est pas active mais potentielle.

Puis nous le lâchons, et il se met à osciller de part et d'autre de la position 0, avec une fréquence f (nombre d'oscillations par seconde) constante. Cette fréquence est déterminée par la force de rappel du ressort. Plus on tire, et plus la force de rappel est grande. Dans ce type d'oscillateur idéal, nommé oscillateur harmonique, la force de rappel est proportionnelle à l'étirement q et s'annule à la position zéro.

La fréquence d'oscillation f est donnée par

où m est la masse du poids.

Lorsque le poids se déplace verticalement, tel une balançoire il prend de la vitesse, perd son énergie potentielle qui se transforme en énergie de mouvement.

À la position q, en désignant par p la quantité de mouvement, l'énergie est donc la somme des deux:

.

Elle reste constante et égale à l'énergie potentielle de départ:

.

Bien avant l'introduction de la notion de quantum en physique, on savait exprimer un champ électromagnétique sous la forme mathématique d'un ensemble de vibrateurs (oscillateurs) en nombre infini (par une simple transformée de Fourier). Un oscillateur, c'est un objet, une particule ou une grandeur telle qu'un champ, qui vibre sur place, à la manière d'une balançoire ou d'un ressort.

On représente donc l'espace comme rempli d'oscillateurs dont les fréquences d'oscillation se répartissent entre 0 à infini.

En physique quantique, il n'est plus possible de définir l'énergie de la même manière qu'en physique classique à cause de l'indétermination de Heisenberg.

Par exemple, si on indique précisément la position de l'oscillateur, alors sa vitesse peut prendre des valeurs quelconques. Aussi faut-il décrire son état par sa fonction d'onde, calculée à partir de l'équation de Schrödinger et de l'hamiltonien du système. Rappelons que l'hamiltonien H est l'expression de l'énergie totale E.

En résolvant l'équation, on trouve que l'énergie de l'oscillateur de fréquence f ne peut prendre que certaines valeurs quantifiées, toutes multiples de la quantité hf plus un résidu 1/2 h, où h est la constante de Planck.

h f = n h f

n est un nombre entier nul ou positif.

L'énergie nhf est considérée comme un ensemble de n corpuscules (photons) virtuels identiques et indiscernables d'énergie hf.

À l'état fondamental n=0 (abscence de photons viruels), on trouve une énergie qui n'est pas nulle.

h f

Contrairement à l'oscillateur classique dont l'énergie au repos est nulle, l'oscillateur quantique a donc toujours une énergie résiduelle.

Le champ est représenté comme un ensemble d'oscillateurs dont la distribution en énergie varie en fonction de la température comme dans le cas d'un gaz.

Parmi les différents niveaux quantifiés n possibles de son énergie, quel est celui que choisit chaque oscillateur? Il a une probabilité d'être dans chacun d'entre eux, et on ne peut que définir une distribution statistique. On en déduit une moyenne de son énergie, qui est fonction à la fois de la fréquence f de l'oscillateur et de la température absolue T.

En physique quantique non-relativiste, c'est la formule de Planck qui donne l'énergie moyenne d'un oscillateur:

où h est la constante de Planck, k la constante de Boltzmann

En physique quantique relativiste, à cause du niveau fondamental non nul de l'énergie des oscillateurs, la formule est modifiée:

Au zéro absolu, l'énergie moyenne Em d'un oscillateur est égale à .

Pour calculer l'énergie totale du vide, il faut dans une première étape multiplier cette énergie par le nombre d'oscillateurs de fréquence f, c'est-à-dire la densité d'oscillateurs (nombre par unité de volume). On obtient la densité d'énergie (énergie par unité de volume) totale pour tous les oscillateurs de fréquence f. Le calcul montre que cette densité d'énergie est proportionnelle au cube de la fréquence: f3. Pour des fréquences très élevées, cela donne une densité d'énergie gigantesque.

Dans une seconde étape, on calcule l'énergie totale du vide en faisant la somme des densités d'énergie de toutes les fréquences.

Accéder aux autres parties:

en anglais

Texte conforme à la nouvelle orthographe française (1990)

24 juillet 2015 - dernière modification 13/02/2016 (restructuration des annexes)